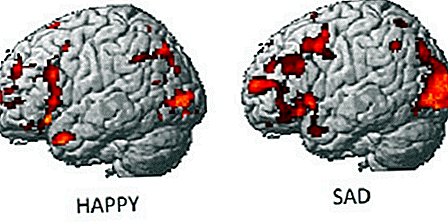

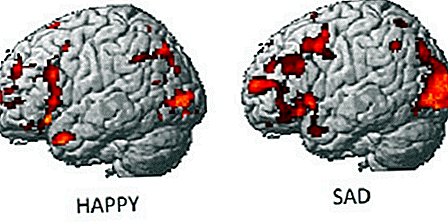

Im letzten Sprung des Gedankenlesens sagen Wissenschaftler, dass sie in der Lage waren, die Emotionen einer Person durch Gehirnscans zu entschlüsseln.

Muster neuronaler Aktivität können verraten, was Menschen denken und fühlen, dh wenn Wissenschaftler Gehirnscans, die durch funktionelle Magnetresonanztomographie (fMRT) erhalten wurden, einen Sinn geben können. In früheren Studien haben Forscher gezeigt, dass sie anhand von Gehirnscans bestimmen können, an welche Zahl eine Person denkt, wo sich Menschen in einer Virtual-Reality-Umgebung befinden, und sogar herausfinden können, wovon eine Person träumt.

In der neuen Studie untersuchten Forscher der Carnegie Mellon University, wo Wut, Ekel, Neid, Angst, Glück, Lust, Stolz, Traurigkeit und Scham im Gehirn leben. Um sicherzustellen, dass die Studienteilnehmer diese Emotionen zuverlässig und wiederholt heraufbeschwören können, wurden 10 Methodenschauspieler aus der Schauspielabteilung der Schule rekrutiert.

"Sie sind wirklich gut darin, sich in diese emotionalen Zustände zu versetzen", sagte der Studienautor Karim Kassam in einem Video von Carnegie Mellon. Die Schauspieler wurden angewiesen, Szenarien für jede Emotion zu schreiben, damit sie auf einem Stichwort in das richtige Gefühl schlüpfen konnten, während sie sich in eine fMRI-Maschine legten.

Bei der Untersuchung der Gehirnaktivität der Akteure stellten die Forscher fest, dass mit jedem emotionalen Zustand neuronale Signaturen verbunden waren und dass diese Signaturen zwischen Einzelpersonen geteilt wurden.

"Trotz offensichtlicher Unterschiede zwischen der Psychologie der Menschen neigen verschiedene Menschen dazu, Emotionen auf bemerkenswert ähnliche Weise neuronal zu kodieren", sagte die Doktorandin und Studienforscherin Amanda Markey in einer Erklärung.

Ein Computermodell, das die Gehirnmuster lernte, die mit den selbstinduzierten Emotionen der Schauspieler verbunden sind, konnte schließlich erraten, welche Emotionen mit einem hohen Maß an Genauigkeit hervorgerufen wurden. Das Modell war am genauesten bei der Identifizierung des Glücks und am wenigsten genau bei der Ermittlung des Neides. Es habe normalerweise keine positiven und negativen Emotionen verwechselt, sagten die Forscher.

Die Lust wurde selten mit einer anderen Emotion verwechselt, und das Muster der neuronalen Aktivität der Lust war nicht mit positiven oder negativen emotionalen Signaturen verbunden, was darauf hindeutet, dass es zu einer ganz anderen Gefühlsklasse gehören könnte.

Die Forscher befürchteten, dass eine Emotion wie Wut, wenn sie von den Schauspielern beschworen wird, sich von der Wut unterscheidet, die der Rest der Bevölkerung spontan erlebt. Um diese potenzielle Ungleichheit in Schach zu halten, entwarfen sie ein zweites Experiment, bei dem die Teilnehmer nicht aufgefordert wurden, selbst Emotionen hervorzurufen, sondern ihnen Bilder gezeigt wurden, die sie abschrecken sollten.

Als die Schauspieler die widerlichen Bilder sahen, sagte das Computermodell voraus, dass sie in 60 Prozent der Fälle Ekel verspürten, und listete Ekel in 80 Prozent der Fälle unter den beiden wichtigsten Vorhersagen auf, stellten die Forscher fest.

Die Wissenschaftler sagten, sie seien überrascht, dass der Computer Emotionen auch nur anhand der Aktivierungsmuster in einem Unterabschnitt des Gehirns genau vorhersagen könne.

"Dies deutet darauf hin, dass Emotionssignaturen nicht auf bestimmte Gehirnregionen wie die Amygdala beschränkt sind, sondern charakteristische Muster in einer Reihe von Gehirnregionen erzeugen", sagte Vladimir Cherkassky, leitender Forschungsprogrammierer in der Abteilung für Psychologie.

Die Scans könnten neue Wege eröffnen, um Emotionen in Studien zu untersuchen, ohne sich auf die Selbstberichterstattung verlassen zu müssen, eine manchmal unzuverlässige Methode, sagten die Wissenschaftler.

"Es könnte verwendet werden, um die emotionale Reaktion eines Individuums auf fast jede Art von Reiz zu bewerten, zum Beispiel auf eine Flagge, einen Markennamen oder einen politischen Kandidaten", sagte Kassam in einer Erklärung.

Die Ergebnisse wurden am Mittwoch (19. Juni) in der Zeitschrift PLOS ONE veröffentlicht.